Nouvelles technologies

ChatGPT. Un entraînement à quel prix ? (3/6)

13.10.2023

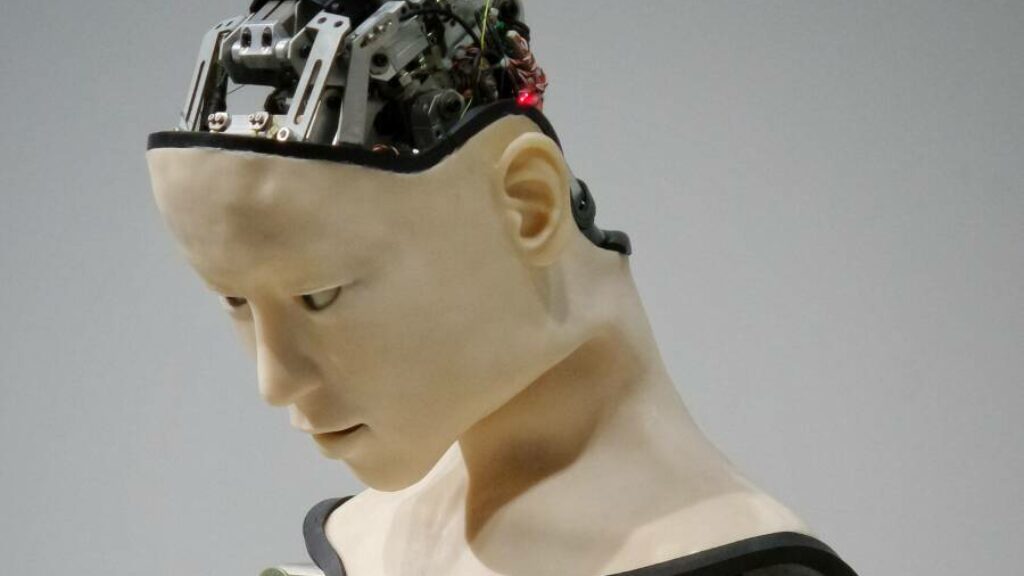

L’entraînement d’une intelligence artificielle générative a pour objectif d’ajuster ses paramètres, de telle sorte que le résultat obtenu corresponde au résultat attendu. Mais celui-ci a un coût, aussi bien humain qu’environnemental.

Comme l’expliquait le premier article de cette série, pour fonctionner, un système d’intelligence artificielle (IA) générative a besoin de volumes gigantesques de données. Ces données forment la base de « l’entraînement » du système, destiné à le rendre performant. Mais, contrairement à ce que l’on pourrait penser, cet « entraînement » n’est pas totalement automatique. Comme derrière tout système technique, il y a des humains qui le façonnent et paramètrent. Dans le monde de l’intelligence artificielle, il n’est pas rare de faire appel à des travailleurs payés chichement, qui ne sont pas forcément experts d’un domaine en particulier, pour annoter des dizaines de milliers de données « d’entraînement ». C’est ce qu’on appelle le crowdsourcing (« recueillir des sources auprès du public »), un procédé qui suscite aussi des interrogations en matière de fiabilité, étant donné qu’il implique la subjectivité du jugement humain.

Des travailleurs derrière la machine

MechanicalTurk est la ressource la plus connue sur ce marché du crowdsourcing. Lancée par Amazon en 2005, cette plateforme de « microservices » rémunère le travailleur selon un tarif par tâche effectuée. Il revient au client de MechanicalTurk de fixer le montant de sa contribution1, dont le minimum est fixé à 0,01 dollar (soit un cent) par tâche effectuée ou « source » encodée. Cela représente un salaire d’entre 1 et 6 dollars (aujourd’hui, entre 0,95 et 5,70 euros) par heure de travail. Une autre forme de crowdsourcing assez répandue et à laquelle nous sommes fréquemment confrontés, c’est celle du processus de validation : pour s’assurer de la nature humaine d’un internaute – et écarter les « robots » –, on lui demande de sélectionner, par exemple, toutes les images avec un pont, une voiture ou une borne d’incendie. C’est ce que les sociologues Dominique Cardon et Antonio Casilli2 appellent le digital labor, le « travail numérique ». Sans le savoir, ou en tout cas sans en avoir conscience, nous sommes donc nombreuses et nombreux à « entraîner » chaque jour des systèmes d’intelligence artificielle. Le monde des Big Tech ne manque pas de (mauvaises) suprises dans son sac à malices.

OpenAI a fait appel à des travailleurs kenyans pour « entraîner » ChatGPT. La motivation de ce choix était d’éviter que le système ne fournisse des réponses violentes ou haineuses : c’est ce qu’on appelle de la « désintoxification ». Ces travailleuses et travailleurs, souvent des jeunes diplômés à la recherche d’un emploi, ont subi pendant de nombreuses heures une exposition initerrompue à tout ce qu’internet diffuse de plus violent. Une expérience traumatisante pour les uns – ces personnes ont été confrontées à des scènes de torture, de viol et de meurtre – mais qui s’est avérée profitable pour d’autres : selon Time Magazine, le montant de la rémunération, lors de cette opération, ne dépassait pas 2 dollars (1,90 euros) par heure de travail3. OpenAI n’y voit pas de souci : Meta, la société mère de Facebook, avait fait pareil quelques années plus tôt, au même tarif.

À l’instar de Meta, OpenAI n’a d’ailleurs pas recruté directement ses travailleurs et travailleuses au Kenya : la société a eu recours à une autre entreprise américaine basée en Californie, Sama. Celle-ci délocalise ses activités en Afrique et en Inde et prétend travailler de manière « éthique ». Elle aurait même quelques intentions humanitaires4 : grâce à elle, pas moins de 50 000 personnes seraient ainsi « sorties de la pauvreté ».

L’impact environnemental

Mais les faces sombres de « l’entraînement » des systèmes d’IA générative ne se trouvent pas seulement dans le domaine de l’emploi. Comme toute technologie numérique, ces systèmes sont gourmands en ressources matérielles – essentiellement des composants électroniques – et en énergie. Compte tenu de la puissance de ses processeurs, le seul système ChatGPT émettrait 8,24 tonnes de dioxyde de carbone par an5, soit un peu moins que l’empreinte carbone du Belge moyen, et son « entraînement » aurait nécessité en une année près de 1 300 MWh6, l’équivalent de la consommation annuelle d’électricité d’environ 300 ménages européens. Ce ne sont là que des estimations d’une précision relative, faute de données plus fiables.

Si on évoque souvent la consommation d’énergie d’un système informatique, on parle plus rarement de l’empreinte hydrique des modèles d’intelligence artificielle. Aux États-Unis, un centre de données ultramoderne peut ainsi consommer annuellement 700 000 litres d’eau douce propre7, un volume qui suffirait pour la production de plus de 300 véhicules électriques. Mais dans ce domaine aussi, on manque de données disponibles pour se faire une idée plus précise du coût environnemental des modèles d’intelligence artificielle générative8.

Ce manque de transparence ne laisse pas d’interpeller, au moment où le Giec vient de publier un nouveau rapport accablant. D’autant plus que toutes les estimations dont on dispose ne tiennent pas compte du type de combustible utilisé dans les centrales électriques qui alimentent les centres de données. Ajoutons qu’OpenAI n’est pas le seul acteur des big tech à développer des systèmes d’IA générative, ce qui signifie que les données évoquées ci-dessus doivent être extrapolées pour englober l’ensemble du secteur.

Faute de pouvoir contrôler les activités énergétiques de sociétés établies en dehors de l’espace européen, les autorités européennes devraient, à tout le moins, exiger d’elles une communication claire à propos de leurs impacts environnementaux. Cela permettrait, au minimum, de prendre conscience de la nécessité d’un regard critique, d’usages responsables et de réponses politiques adaptées aux enjeux climatiques.